初次体验研讨会,感觉其意义大致在于拓宽视界、开拓思路、结交同行,附带有一些大大小小的企业在招聘,可谓是领域学术界和工业界的一次「盛会」了。简单回顾一下。

肝MICCAI的时候,今年的VALSE (Vision And Learning SEminar,视觉与学习青年学者研讨会) 网上申请入口开放,比较幸运报上了名。等到4月11日,正式动身前往合肥。

VALSE2019

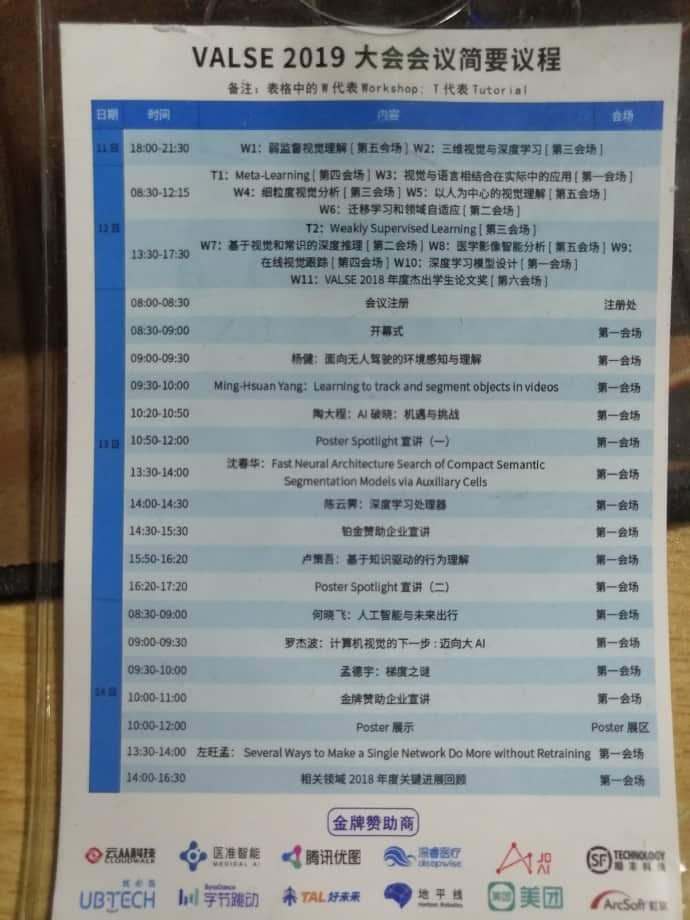

研讨会持续三天,第一天以Workshop和Tutorial为主,可以选择自己感兴趣的听,后两天则是主题式的宣讲以及Poster Spotlight。值的一提的是每个Workshop最后都有一个座谈会环节,演讲大咖嘉宾会就某一些热点话题发表各自的意见,可以听到这些学术界内该领域的大佬对某些问题的具体看法。有的时候,我们问不出很有价值的问题,或者没有机会向这么多的大咖同时发问,这个环节就很有价值了。 大会的总体行程如下图:

特意去听了杰出学生论文奖,前三个里面有两个是清华的学生,最让我感叹的是他们即使做还是「黑盒」的神经网络,依然有很强的数学推导与解释能力,这是我现阶段所欠缺比较多的。

关于神经网络安全性

因为是导师组内第一个做神经网络安全性问题的,又没有高年级的师兄可以提供学术上的建议,所以做了半年感觉进步并不大。很多细节,和一些Poster讨论后,才有了融会贯通的感觉。接触到清华大学朱军老师团队的两个成员:Yinpeng Dong和Tianyu Pang,他们团队做神经网络安全性有几年的积累了。这里聊几点关于攻防的收获。

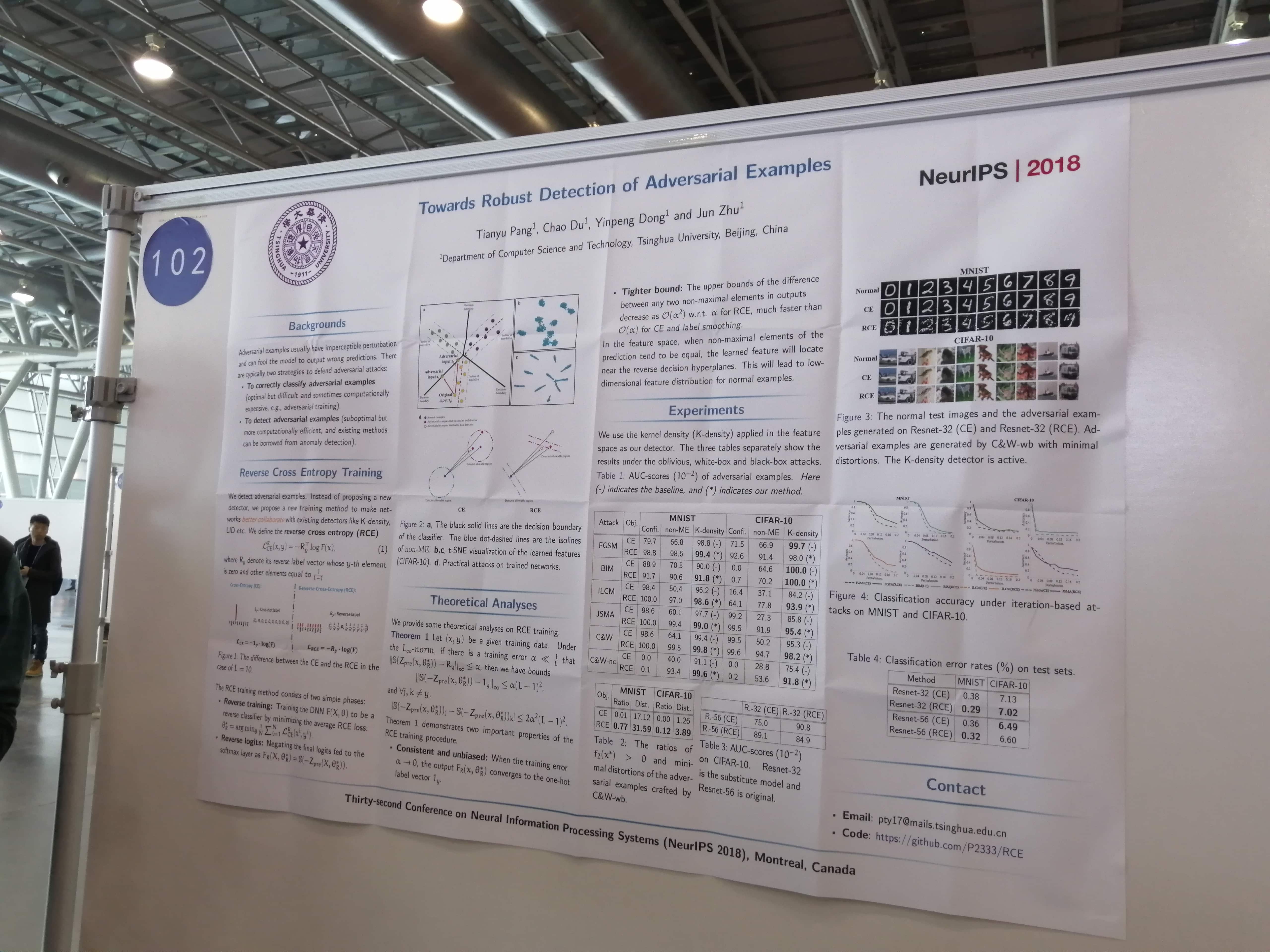

Detection

Tianyu Pang在NIPS2018年上发表了一篇用作对抗样本检测的论文,出发点很清奇。

现有的分类神经网络可以可以大致分为两个阶段:

- 第一阶段是特征提取,一般由卷积操作堆叠,这是一个非线性的过程,非线性主要由激活函数提供。

- 第二阶段是分类器,一般由全连接层即Linear层组成,这是一个线性的过程,主要起到将学到的“分布式特征表示”映射到样本标记空间的作用。

这两个阶段中,我们一般不对features进行交互,而是通过分类器得到的logits,再通过loss操作进行反向传播。

我们熟悉的交叉熵损失函数CE(Cross Entropy)中,对target的设置是one-hot类型的,正确的类设为1,其他类设为0,这样做有什么缺点呢?这样其实我们在backward的时候,丢失了其他类之间的约束关系,因为我们只关注正确的类,只更新和它相关的参数,而其他类特征之间是不是存在一定的约束关系呢,这样的信息是不是有用呢?总之,这部分的信息,我们一般处理是丢失的。

所以就想到对CE进行改进-> RCE(Reverse Cross Entropy)。 将原本的one-hot的target进行修改,正确类设为0,其他类设为1/L,L表示类别数目。

文章内容这里不再细说。聊一下这篇文章让我触动比较大的地方。首先是对神经网络与损失函数的理解;其次是其对特征分布的理解,不仅有抽象,还有理论的解释;最后则是实验的一些设计。

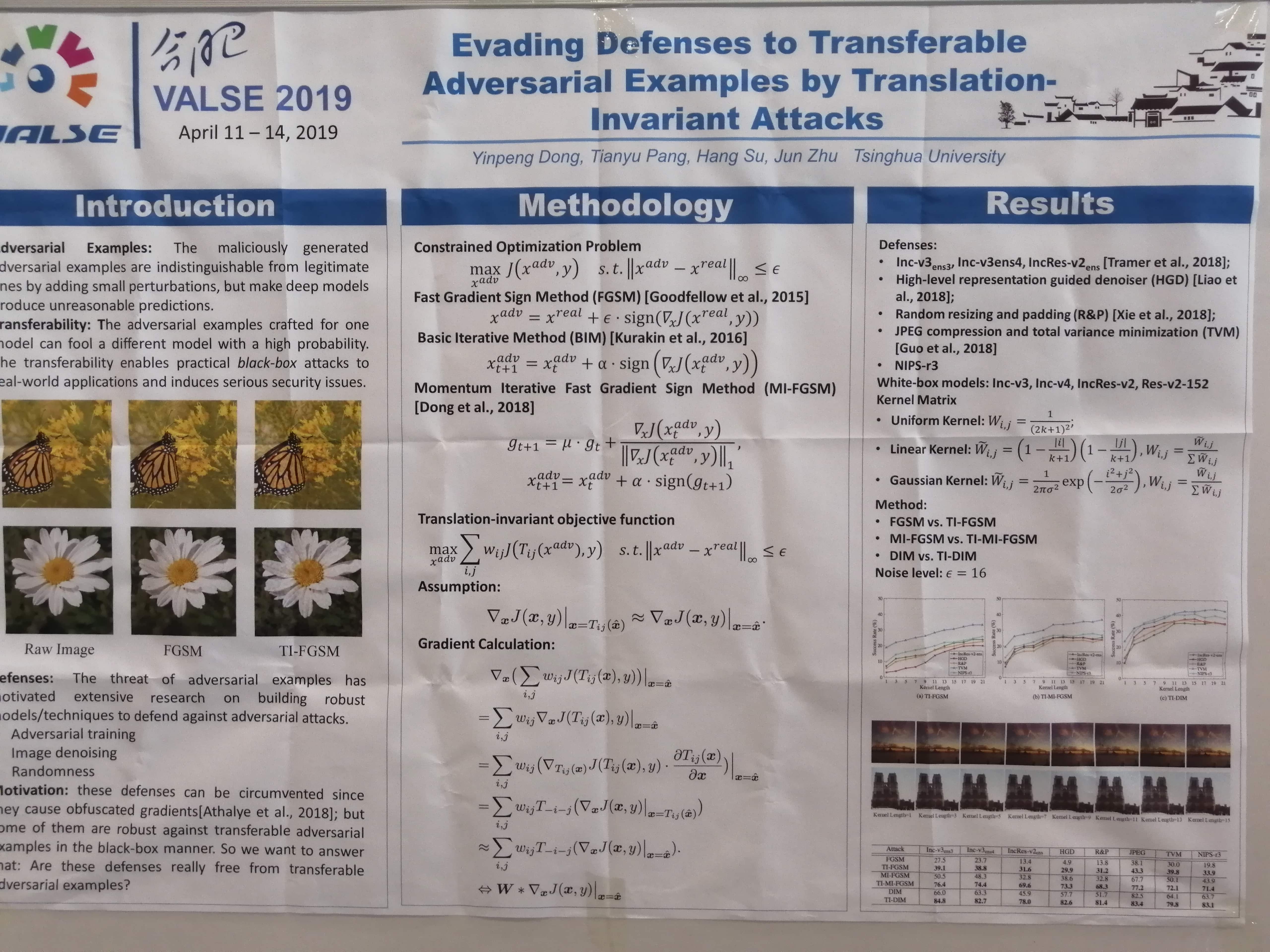

Attack

Yinpeng Dong应该可以称得上参与这届研讨会的学生的巅峰了吧。他做的工作主要是关于神经网络安全性中的攻击。2018年高产,中了3篇顶会,其中一篇Oral。这里简单提一篇他做的迁移变换的攻击方法。

文章的出发点在于现阶段的梯度攻击(以FGSM和I-FGSM为主),其攻击都依赖于梯度,迁移变换的想法是,将梯度进行领域内的迁移变换。文章也通过公式理论推导,将作用于单个像素领域的问题转换为作用于整个feature map的变换函数。最后辅以大量的实验作证。

关于其他Poster

纵观全场,发现Poster最多的主题是人脸三维重建。其次也有很多的图网络相关内容。也有很多团队提出一些新颖的架构,比如欧阳万里老师所在团队提出的FishNet。这些结构上的变动,往往给人一种还可以这样做的启发。我就在想,这些结构既然具有这样那样的性质,应用到神经网络安全性上是不是也会有作用呢?

还有一些收获呢,需要再精读论文进行消化。

关于合肥

物价水平和广州比起来,真的是便宜太多了!痛痛快快吃了一顿地锅鸡,最后半天逛了徽园。

最后合影留念: